Wrist World技术作为机器人空间感知领域的革命性创新,核心突破在于通过跨系统协同实现从“第三人称”视角到“第一人称”操作视角的精准转换,成功破解了传统机器人精细操作的数据瓶颈与自监督学习难题。这项技术的顺畅运行并非依赖单一模块的独立作用,而是建立在硬件部件、软件系统与算法引擎深度联动的基础上,构建起感知-计算-决策-反馈的完整闭环体系。要理解其背后的运行逻辑,可从核心硬件部件、关键软件系统及跨模块联动机制三个维度展开详细解析。

核心硬件部件——空间感知的物理基础

硬件部件是Wrist World技术实现空间数据采集与指令执行的物理载体,所有设备都围绕高精度、低延时、多维度的数据捕获需求设计,共同构成技术落地的基础支撑。

视觉采集作为Wrist World技术获取第三人称画面的核心入口,需要多类型摄像头协同工作以确保场景信息的全面覆盖与细节捕捉。其中,外部全景摄像头采用分辨率不低于4K的高分辨率RGB摄像头,搭配110°以上大视场角镜头,负责采集机器人操作场景的全局第三人称画面,精准捕捉环境布局、操作目标位置及机器人肢体运动轨迹,为视角转换提供基础图像数据;部分高端方案还会集成鱼眼镜头,进一步扩大覆盖范围,更好适配复杂操作场景。

深度感知设备则通过双目视觉相机与TOF(飞行时间)传感器的结合构建三维空间感知能力,双目相机通过计算视差获取环境深度信息,在强光环境下表现优异,有效距离可达5.5米,误差控制在3%以内;TOF传感器采用940nm抗干扰波长,在0.2-4米范围内实现误差小于1%的超高精度深度测量,输出深度图与点云数据,弥补双目相机在暗光环境下的不足,两者协同为4D世界模型提供可靠的三维空间数据支撑。此外,安装于机器人手腕关节附近的手腕局部摄像头,专门采集手腕动作的局部细节画面,用于校准视角转换后的第一人称画面精度,确保握持、翻转等精细动作的视觉还原准确性。

为实现手腕位置的准确估计,定位与姿态感知部件需实时捕获机器人肢体的空间位置与运动状态。集成于机器人手腕及各关节处的惯性测量单元(IMU),包含加速度计、陀螺仪与磁力计,能够实时采集关节运动的加速度、角速度数据,刷新率可达1000Hz以上,为手腕位置估计提供动态运动参数,辅助视觉数据完成空间坐标校准。安装于机器人伺服电机中的编码器,通过记录电机旋转角度计算关节位移量,精度可达0.1°以下,可精准追踪手腕及手臂的运动轨迹,为视角转换提供肢体运动的精确坐标参考。在部分高端应用中,还会集成VSLAM(视觉即时定位与建图)模组,通过自研SLAM算法实现机器人自身定位与环境建模,支持实时回环检测与空间锚点辅助定位,进一步提升复杂环境下手腕位置估计的稳定性。

Wrist World技术需要处理海量视觉与传感器数据,这对计算速度与数据传输效率提出了严苛要求。边缘计算单元采用高性能SOC(系统级芯片),集成独立CNN(卷积神经网络)引擎,能够实现本地化实时数据处理,避免云端传输带来的延时问题;该单元支持多线程并行计算,可同时处理多路视频流与传感器数据,完成图像预处理、特征提取与视角转换运算,确保第一人称画面生成延时控制在毫秒级。高速通信接口则通过USB Type-C或以太网接口连接器实现各部件与计算单元的连接,支持不低于10Gbps的数据传输速率,同时兼容ROS/ROS2开发框架,保障视觉数据、传感器数据与计算指令的高效传输;部分方案会集成工业以太网连接器,进一步提升抗干扰能力,更好适配工业级操作场景。

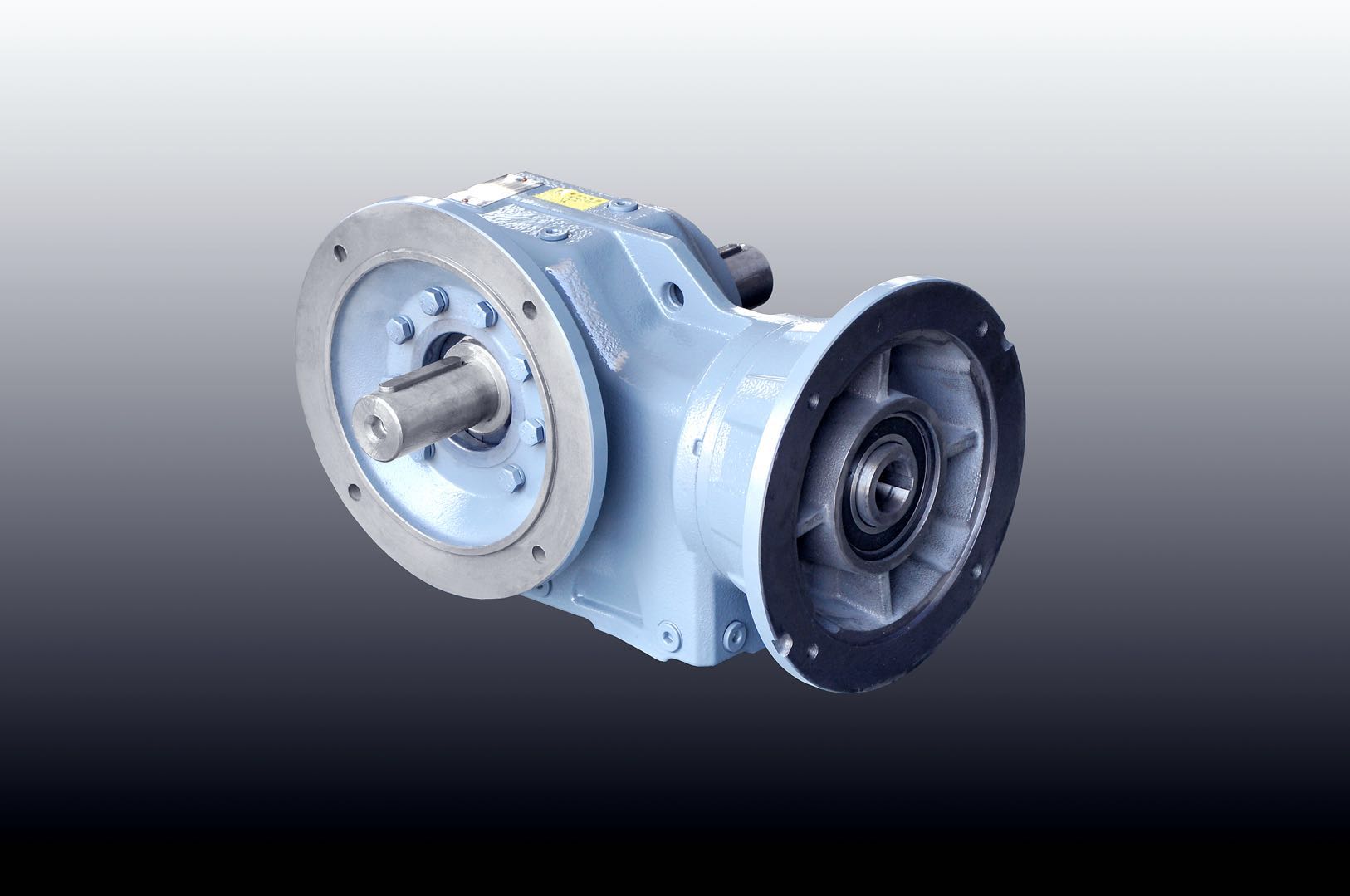

机器人的精细操作需要通过执行部件完成,而操作效果则依赖反馈部件验证。作为关节驱动核心的伺服电机,具备高精度位置控制能力,响应时间低于5ms,配合编码器可实现手腕及手臂的精准运动,确保第一人称视角指导下的动作执行精度。安装于机器人手部末端的触觉传感器,能够采集抓取力度、接触压力等触觉数据,不仅可以反馈操作效果,辅助自监督学习优化动作策略,还能为视角转换提供操作场景的触觉-视觉关联数据。

线束则分为动力线束与信号线束,动力线束为伺服电机提供高载流电力支持,保障高强度工作下的动力稳定;信号线束精准传递触觉传感器、编码器的反馈数据,传输延迟控制在微秒级,为自监督学习的闭环校准提供效率保障。考虑到机器人手腕关节的高频运动特性,连接器及线束需具备极强的柔性与抗疲劳性,同时满足小型化、抗干扰设计要求,避免运动过程中出现接触不良——其性能直接影响Wrist World技术视角转换误差的控制效果,优质的连接系统可助力将视角转换误差缩小42.4%以上,成为实现精细操作的关键支撑。

关键软件系统——数据处理与智能决策的核心大脑

如果说硬件部件是Wrist World技术的筋骨,那么软件系统就是其核心大脑,通过多模块协同完成数据加工与智能决策,实现视角转换、自监督学习与空间重建等核心功能。

多模态数据融合系统作为信息整合的中枢平台,负责接收视觉、定位、姿态等多源数据,通过数据校准与融合算法消除不同设备的误差,形成统一的数据集。在数据同步校准方面,该系统采用时间戳同步技术,将摄像头、IMU、编码器等设备的数据流统一到同一时间轴上,避免数据延迟导致的空间坐标偏差;同时通过标定算法修正摄像头畸变与传感器误差,确保所有数据的一致性。在多源数据融合环节,则运用卡尔曼滤波、贝叶斯估计等算法,将视觉数据的环境信息、IMU的运动数据、编码器的位置数据融合为统一的空间状态向量,为4D世界模型提供全面、准确的输入数据。

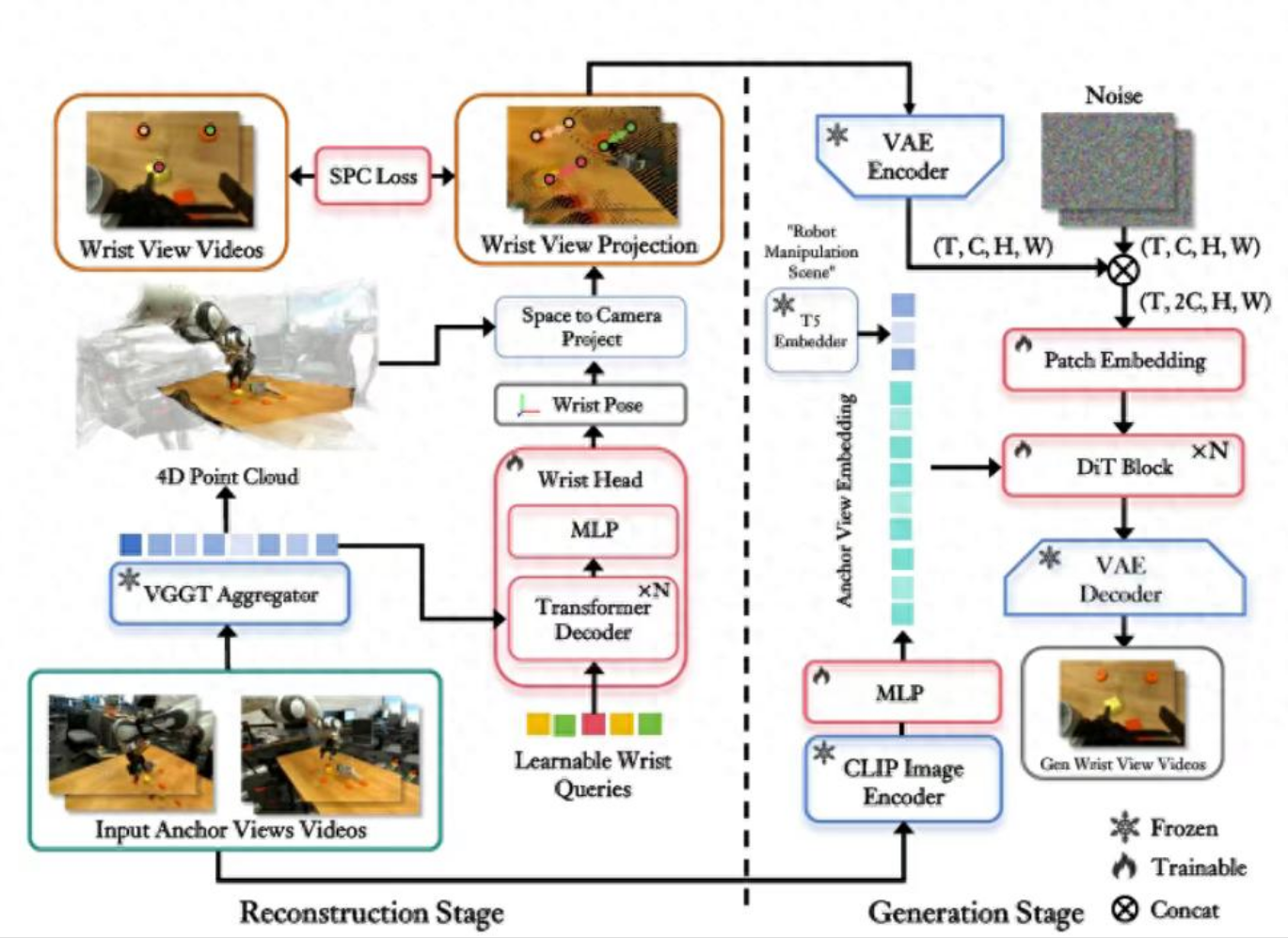

4D世界模型系统是Wrist World技术的核心所在,通过融合三维空间数据与时间维度信息,构建动态可交互的场景模型,这也是实现视角转换的核心逻辑。在三维空间重建方面,系统基于双目相机与TOF传感器的深度数据,通过点云拼接、网格重建算法构建操作场景的三维模型,精准还原环境布局、操作目标的三维形态及机器人肢体的空间位置关系。时间维度建模则通过整合IMU与编码器的运动数据,记录机器人动作的时间序列变化,构建动态运动轨迹模型,捕捉手腕从初始位置到操作位置的完整运动过程,为视角转换提供时间维度的动作连续性支撑。视角转换算法作为关键环节,基于三维空间模型与运动轨迹数据,运用透视变换、视图合成算法,从第三人称全局画面中提取并生成手腕视角的第一人称操作画面;算法通过学习人类视角转换的视觉规律,能够自动补偿遮挡区域信息,确保第一人称画面的完整性与准确性。

自监督学习系统是Wrist World技术摆脱人工标注依赖的关键,通过内置算法实现手腕位置估计与视角转换精度的自主优化。在无监督特征提取环节,系统运用卷积神经网络(CNN)、Transformer模型等深度学习模型,自动从海量未标注的第三人称画面中提取关键特征,包括手腕轮廓、操作目标特征、环境纹理信息等,构建完善的特征数据库。闭环校准机制则将生成的第一人称画面与手腕局部摄像头采集的真实画面进行比对,计算视角转换误差,通过反向传播算法调整4D世界模型的参数,优化视角转换精度;同时结合触觉传感器的反馈数据,验证操作动作的有效性,自主修正手腕位置估计模型,形成数据采集-模型优化-精度提升的闭环学习。此外,迁移学习模块能够将已学习的视角转换能力迁移到新的操作场景中,通过少量场景适配数据快速调整模型参数,提升技术的场景适应性,减少新场景下的训练成本。

实时控制系统承担着指令执行的调度中枢职责,负责将视角转换后的第一人称画面与操作指令结合,驱动机器人完成精细动作。在动作规划方面,系统基于第一人称画面中的目标位置与环境信息,规划手腕及手部的运动路径,避开碰撞风险,确保操作动作的流畅性与精准性。在指令下发与反馈环节,系统将规划好的动作指令转化为伺服电机的控制信号并实时下发,同时接收编码器与触觉传感器的反馈数据,动态调整动作参数,确保操作精度符合预期要求。

跨模块联动机制——技术运行协同

Wrist World技术的高效运行,最终依赖硬件部件与软件系统的无缝协同,形成采集-处理-建模-转换-执行-优化的全流程联动机制。

在数据采集阶段,外部全景摄像头与深度感知设备同步采集第三人称全局画面与三维空间数据,IMU、编码器实时捕获机器人手腕的运动状态与位置信息,这些多源数据通过高速通信接口传输至边缘计算单元,由多模态数据融合系统完成同步校准与整合,为后续处理提供统一、精准的数据集。

进入建模与转换阶段,整合后的数据集被输入4D世界模型系统,构建包含空间维度与时间维度的动态场景模型;视角转换算法基于该模型,结合手腕运动轨迹数据,生成第一人称操作画面,同时通过手腕局部摄像头采集的真实画面进行初步校准,确保画面的准确性。

在学习与优化阶段,自监督学习系统对比第一人称生成画面与真实画面的差异,结合触觉传感器的操作反馈,自主优化视角转换算法与手腕位置估计模型,持续提升数据精度,整个过程无需人工标注介入,实现自主迭代升级。

最后到执行与反馈阶段,实时控制系统基于优化后的第一人称画面,规划精细操作指令并下发至伺服电机,驱动机器人完成握持、翻转等动作;在执行过程中,各传感器持续采集数据,动态调整动作参数,确保操作效果符合预期。

这一联动机制的核心优势在于实现了数据采集-智能处理-自主优化-精准执行的闭环运行,既从根本上解决了第一人称数据稀缺的瓶颈,又通过自监督学习持续提升系统精度,为机器人在精密制造、医疗手术等对操作精度要求极高的领域提供了可靠的技术支撑,也为机器人空间感知技术的发展开辟了新的方向。

未来,随着硬件小型化、算法轻量化与连接系统高性能化的持续推进,Wrist World 技术将不断突破精度与场景适配的限制,推动机器人产业迈入更高效、更灵活的发展新阶段,为人机协同的智能化未来注入持久革新力量。